تکنولوژی دیپ فیک چیست و چطور کار میکند؟ + ۵ راه برای تشخیص آن

آیا مصاحبه ای را دیده اید که باراک اوباما، در آن دونالد ترامپ را “احمق” خطاب کند؟ یا مارک زاکربرگ در مورد “کنترل کامل روی میلیاردها گیگابایت داده که از مردم سرقت شده است” بلف بزند؟ یا عذرخواهی جان اسنو را برای پایان ناخوشایند سریال Game Of Thrones را شاهد بوده اید؟ اگر پاسخ شما “بله” است، شما ویدیوهای دیپ فیک (Deepfake) را دیده اید.

deepfake از نوعی هوش مصنوعی به نام یادگیری عمیق برای ایجاد تصاویر از اتفاقات جعلی استفاده میکنند، به همین دلیل deepfake (جعل عمیق) نام گرفته است. میخواهید در دهان یک سیاستمدار حرف بگذارید؟ بازیگر فیلم مورد علاقه خود باشید؟ یا مانند یک حرفه ای برقصید؟ تمام اینها با تکنولوژی دیپ فیک امکان پذیر است![/vc_column_text][vc_custom_heading text=”آیا با تکنولوژی دیپ فیک فقط ویدیو جعل میشود؟” font_container=”tag:h2|text_align:right” use_theme_fonts=”yes”][vc_empty_space][vc_column_text]خیر. هوش مصنوعی با تکنولوژی دیپ فیک میتواند از عکسهای خیالی اما کاملاً قانع کننده بسازد. کتی جونز یک شخصیت ساختگی بود که در یک پروفایل جعلی در لینکدین ادعا کرد که در مرکز مطالعات استراتژیک و بین المللی کار میکند، اما این ماجرا یک دیپ فیک بود برای یک عملیات جاسوسی خارجی شکل گرفته بود.

حتی صدای شخصیتهای معروف هم میتواند با تکنولوژی دیپ فیک تقلید شود. مارس سال گذشته، رئیس یک شرکت انگلیسی که زیرمجموعه یک شرکت آلمانی فعال در حوزه انرژی است، پس از تماس تلفنی با یک کلاهبردار که صدای مدیر عامل شرکت آلمانی را جعل کرده بود، ۲۰۰،۰۰۰ پوند به یک حساب بانکی در مجارستان واریز کرد. شواهد نشان میدهند که صدای مدیر عامل شرکت آلمانی دیپ فیک بوده است. گفته میشود کلاهبرداریهای مشابه با استفاده از جعل صدا با تکنولوژی دیپ فیک و ارسال آن در واتس اپ نیز گزارش شده است.[/vc_column_text][vc_custom_heading text=”تکنولوژی دیپ فیک چطور کار میکند؟” font_container=”tag:h2|text_align:right” use_theme_fonts=”yes”][vc_empty_space][vc_column_text]

روش اول

روشهای مختلفی برای ایجاد deepfakes وجود دارد، اما رایج ترین آنها از یک الگوریتم هوش مصنوعی به نام شبکههای عصبی عمیق استفاده میکند؛ این الگوریتم متکی به روشی است که در آن دو چهره با هم جابهجا میشوند. شما ابتدا به یک فیلم هدف نیاز دارید تا به عنوان پایه دیپ فیک استفاده شود و چره شخص مورد نظر در آن جاگذاری شود. سپس مجموعه ای از عکسها و یا کلیپها از شخصی نیاز دارید که میخواهید چهره اش را جعل کنید.

فیلمی که به عنوان هدف در نظر گرفته میشود میتواند کاملاً بی ربط باشد. مثلا فیلم هدف ممکن است یک کلیپ از یک فیلم هالیوودی باشد، و فیلمهای شخصی که میخواهید در فیلم هدف وارد کنید ممکن است کلیپهای دانلود شده از YouTube یا هر فیلم دیگری باشد.

Autoencoder یک برنامه هوش مصنوعی مبتنی بر یادگیری عمیق است که وظیفه دارد چهره فرد را از زوایای مختلف در کلیپهای ویدئویی بررسی کند تا با یافتن ویژگیهای مشترک، چهره آن شخص را در فیلم مورد نظر بر روی چهره فرد اصلی جعل یا جاگذاری کند.

در این مرحله نوع دیگری از الگوریتم یادگیری ماشین اضافه میشود، که معروف به General Adversarial Networks (GANs) است. این الگوریتم وظیفه دارد تا نقاط ضعف و عدم تشابهات را در چهره جعل شده شناسایی کرده و آنها را بهبود بخشد. در واقع کار این الگوریتم این است که تشخص چهره جعل شده از چهره واقعی را دشوار و یا ناممکن کند.

روش دوم

برای ساخت دیپ فیک یک روش دیگر هم وجود دارد که کمی پیچیده تر است. این روش از طریق جابهجایی دو چهره در فیلم انجام میشود. چند مرحله طول میکشد تا جابهجابی چهرهها انجام شود. ابتدا چندین عکس از دو شخص را از طریق یک الگوریتم هوش مصنوعی به نام Encoder اجرا میشود. Encoder شباهتهای دو چهره را یافته، آنها را یاد میگیرد و تصاویر را در این مرحله فشرده میکند. دومین الگوریتم هوش مصنوعی به نام Decoder برای بازیابی چهرهها از تصاویر فشرده آموزش داده میشود. از آنجا که دو چهره داریم، به یک Decoder آموزش داده میشود تا صورت اول شخص را شناسایی و بازسازی کند و یک Decoder دیگر برای شناسایی و بازسازی صورت شخص دوم آموزش داده میشود. برای جابهجایی چهرهها، در این مرحله تصاویر به Decoder اشتباه نشان داده میشوند. به عنوان مثال، یک تصویر فشرده از چهره شخص A به Decoder دوم که با چهره شخص B آموزش دیده است ، نشان داده میشود. Decoder دوم سپس چهره شخص B را برای ساختن آن آموزش دیده است، با ویژگیها و حالات چهره شخص A بازسازی میکند.[

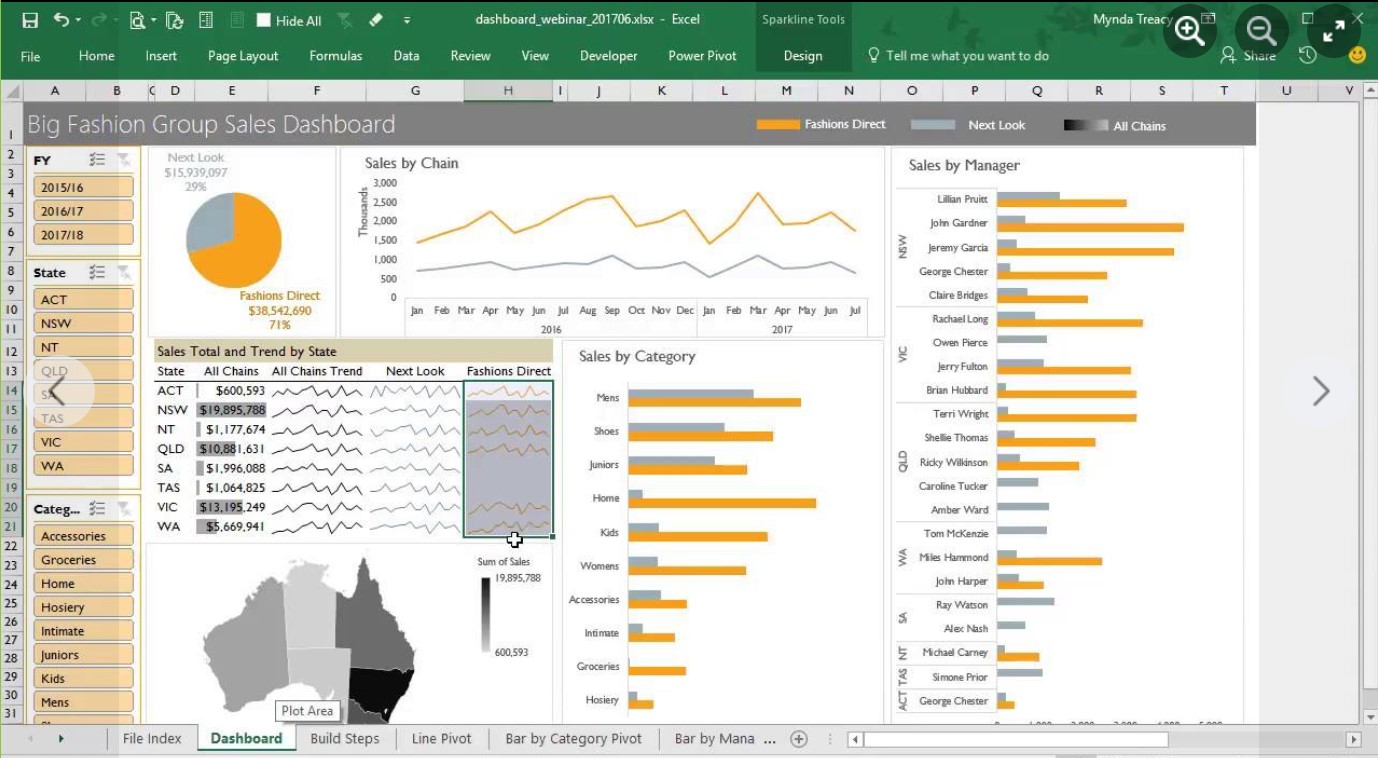

جعل تصویر ولادیمیر پوتین با تکنولوژی دیپ فیک

ساخت دیپ فیک با کامپیوترهای معمولی امکان پذیر نیست و نیاز به پردازندههای گرافیکی پر قدرت و فضای ابری دارد. اما برنامههای متعددی برای موبایل تولید شده است که دیپ فیک را حتی برای مبتدیان آسان میکند، مانند برنامه چینی Zao ، DeepFace Lab ، FaceApp (که یک برنامه ویرایش عکس با تکنیکهای داخلی AI است) و Face Swap. این برنامهها برای سرگرمی مورد استفاده قرار میگیرند و به همین دلیل ایجاد دیپ فیک توسط آنها غیرقانونی اعلام نشده است؛ در حالی که احتمال زیادی دارد از آنها سو استفاده شود.چطور دیپ فیک را از واقعیت تشخیص دهیم؟” همانطور که تاکنون هم در مورد امنیت سایبری اتفاق افتاده است، برای کشف و جلوگیری از گسترش چنین تکنولوژیهایی باید از خود هوش مصنوعی کمک گرفت که به نوبه خود میتواند یک چرخه معیوب ایجاد کند و به طور بالقوه آسیب بیشتری برساند. اما در این سطح از پیشرفت تکنولوژی دیپ فیک، راههایی وجود دارد تا از طریق آنها یک عکس یا ویدیوی جعل شده را تشخیص دهید:

- تکنولوژی دیپ فیک فعلی در متحرک سازی چهرهها با مشکل روبرو میشود و نتیجه آن ویدیویی است که در آن سوژه هرگز پلک نمیزند، یا خیلی زیاد و غیر طبیعی پلک میزند. که البته جای تعجب نیست؛ چون افراد در اکثر عکسها چشمهایشان باز است، بنابراین الگوریتمهای هوش مصنوعی هرگز درمورد پلک زدن چیزی یاد نمیگیرند. با این حال، پس از آنکه محققان دانشگاه آلبانی مطالعه ای را برای شناسایی ناهنجاری چشمک زدن منتشر کردند، دیپ فیکهای جدیدی منتشر شد که دیگر این مشکل را نداشتند.

- به دنبال وجود ناهماهنگی در پوست یا موی شخص باشید؛ به خصوص در جایی که تارهای مو در حاشیه عکس قابل مشاهده هستند. هم چنین چهرهها ممکن است از محیط اطرافشان تار تر به نظر رسد. جواهرات و دندانهایی که بد بازسازی شدهاند و افکتهای نورپردازی عجیب و غریب مانند انعکاس نور درعنبیه چشم، میتوانند دیپ فیک را لو دهد.

- به لبه صورتهای جابهجا شده دقت کنید، تکنولوژی دیپ فیک هنوز نمیتواند لبههای چهره را بدون نقص جابهجا کند و در طول مدت یک ویدیو، هنگام حرکت کردن سر سوژه، احتمال زیادی دارد که بتوانید دیپ فیک را تشخیص بدهید.

- آیا نور عکس یا ویدیو غیر طبیعی به نظر میرسد؟ اکثر الگوریتمهای deepfake نور کلیپهایی را که به عنوان مدل برای فیلم جعلی مورد استفاده قرار گرفتهاند حفظ میکنند، که با نورپردازی در ویدیوی هدف مطابقت ندارد.

- صدای ویدیو با حرکات دهان شخص مطابقت ندارد، به خصوص اگر صدای اصلی فیلم جعلی با دقت دستکاری و تنظیم نشده باشد.

نظر شما چیست؟

نظرات کاربران